Facebook、普林斯顿大学和麻省理工学院的 AI 研究人员近日宣布联合出版了一本名为《The Principles of Deep Learning Theory: An Effective Theory Approach to Understanding Neural Networks(深度学习理论原理:理解神经网络的一种有效理论方法)》的书籍。目前,该书的手稿已经公开提供。

根据介绍,在基本层面上,该书提供了一个从第一性原理(first principles)理解深度神经网络(DNN)的理论框架。对于 AI 从业者来说,这种理解可以大大减少训练这些 DNN 所需的试验和错误的数量。例如,它可以揭示任何给定模型的最佳超参数,而不需要通过今天所需的时间和计算密集型实验。

Facebook AI 研究科学家 Sho Yaida 称,DNN 是现代 AI 研究的关键要素之一。但对于包括大多数 AI 研究人员在内的人都认为,DNN 太过复杂,无法从第一性原理的角度来理解。这一问题的存在意味着,尽管业界已通过实验和反复试验在 AI 方面取得了很大进展,但研究人员对 DNN 的许多关键特性仍一无所知,而这些特性恰恰使得 DNN 极其有用。他认为,如果研究人员对这些关键特性有更深入的了解,可能会带来一些显著的进步,并开发出强大得多的 AI 模型。

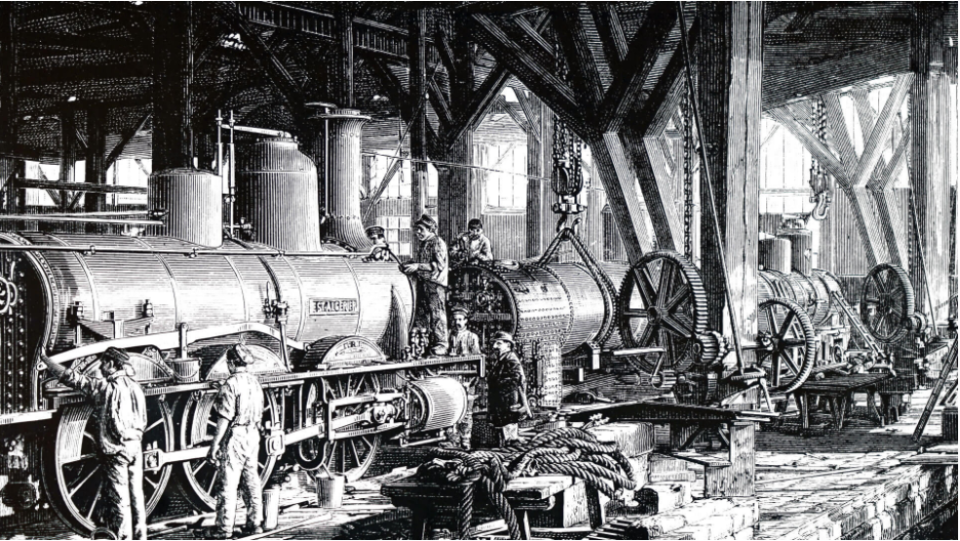

Yaida 将 AI 与工业革命初期的蒸汽机进行了比较。并表示,虽然蒸汽机永远改变了制造业,但直到接下来的一个世纪热力学定律和统计力学原理得到发展,科学家们才能够在理论层面上充分解释它是如何工作的以及为什么工作。虽然缺乏了解的这个问题并没有阻止人们改进蒸汽机,但热机原理的发现却大大加快了改进的步伐。

Yaida 指出,AI 领域目前就正处于类似的关头。DNN 被视为黑匣子,因太过复杂导致无法从第一性原理的角度来理解。因此,AI 模型通过反复试验加以微调,类似于人们改进蒸汽机的方式。不过 Yaida 也表示,试错并不一定是坏事,它可以结合多年形成的经验来巧妙进行。但试错也只是描述 DNN 及其实际运作方式的统一理论语言的替代品。

公告指出,此书只是重新构想 AI 科学这一更大项目的第一步,该项目既源自第一性原理,同时又专注于描述现实模型的实际工作方式。如果成功,这种深度学习的一般理论可能会支持更强大的人工智能模型,甚至可能引导我们建立一个研究智能通用方面的框架。

值得注意的是,虽然书中描述的框架可以扩展到现代 AI 社区使用的真实世界 DNN。但此书本身最主要的还是关注最简单的深度学习模型(深度多层感知器)。

有了这个新的有效理论,我们希望 AI 理论家能够推动对神经网络有更深入、更全面的理解。还有很多的东西需要计算,但这项工作有望使这个领域更接近了解这些模型的哪些特定属性使它们能够智能地执行。我们还希望这本书能够帮助 AI 社区减少有时会限制当前进展的试错循环。我们希望帮助从业者快速设计更好的模型——效率更高、性能更好、训练更快。特别是,那些设计 DNN 的人将能够在没有任何训练的情况下选择最佳超参数,并选择最佳算法和模型架构以获得最佳结果。

更多详情可查看官方博客。