内容简介:Apache Flink 1.14.0 现已发布,Apache Flink 是一个开源的流处理框架,适用于分布式、高性能的数据流应用,是 Apache 软件基金会最活跃项目前 5 名。此版本在 SQL API、更多连接器支持、检查点和 PyFlink 等领域...

Apache Flink 1.14.0 现已发布,Apache Flink 是一个开源的流处理框架,适用于分布式、高性能的数据流应用,是 Apache 软件基金会最活跃项目前 5 名。此版本在 SQL API、更多连接器支持、检查点和 PyFlink 等领域带来了许多新功能和改进。

统一的批处理和流处理体验

- 检查点和有界流

- 通过 FLIP-147,Flink 现在支持任务完成后的检查点,并在有界流的末尾获取最终检查点,确保在作业结束之前提交所有接收器数据(类似于 stop-with-savepoint 的行为)。要激活此功能,请将 execution.checkpointing.checkpoints-after-tasks-finish.enabled: true 添加到配置中。

- 混合数据流和表/SQL 应用程序的批处理执行

- 在 Flink 1.14 中,有界批处理执行的 SQL/Table 程序可以将中间 Table 转换为 DataStream,应用一些 DataSteam API 操作,并将其转换回 Table。此外,Flink 构建了一个数据流 DAG,将声明式优化的 SQL 执行与批处理执行的 DataStream 逻辑混合在一起。

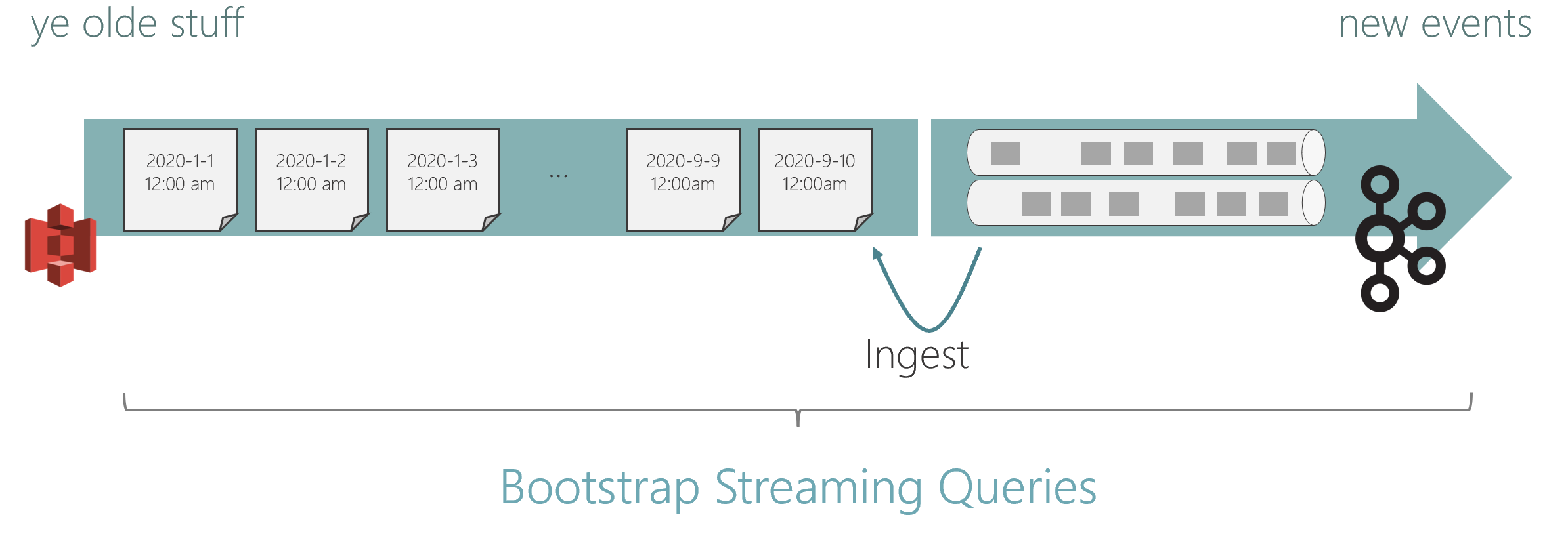

- 混合源

- 现在支持来自多个源的组合流,通过一个接一个地读取这些源,实现从一个源无缝切换到另一个源。比如从分层存储设置中读取流,就好像有一个跨所有层的流。混合源可以将其作为一个连续的逻辑流读取,从 S3 上的历史数据开始,过渡到 Kafka 中更新的数据。

- 现在支持来自多个源的组合流,通过一个接一个地读取这些源,实现从一个源无缝切换到另一个源。比如从分层存储设置中读取流,就好像有一个跨所有层的流。混合源可以将其作为一个连续的逻辑流读取,从 S3 上的历史数据开始,过渡到 Kafka 中更新的数据。

操作改进

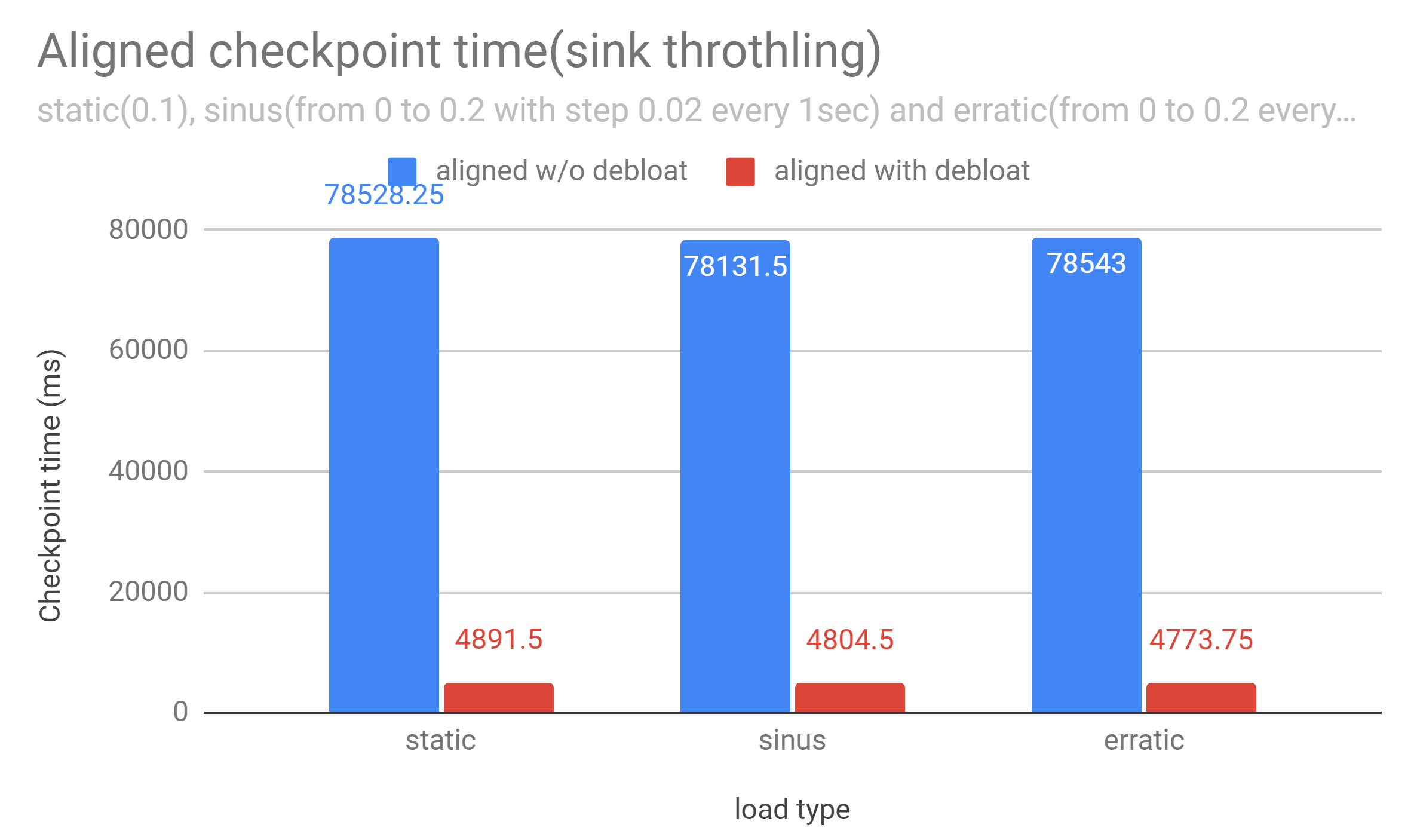

- 缓冲区的去浮动化

- Buffer Debloating 是 Flink 中的一项新技术,可以最大限度地减少检查点延迟和成本。它通过自动调整网络内存的使用来确保高吞吐量,同时最大限度地减少传输中的数据量。因此,Flink 现在可以为背压下的对齐检查点提供稳定且可预测的对齐时间,并且可以大大减少背压下未对齐检查点中存储的动态数据量。

- Buffer Debloating 是 Flink 中的一项新技术,可以最大限度地减少检查点延迟和成本。它通过自动调整网络内存的使用来确保高吞吐量,同时最大限度地减少传输中的数据量。因此,Flink 现在可以为背压下的对齐检查点提供稳定且可预测的对齐时间,并且可以大大减少背压下未对齐检查点中存储的动态数据量。

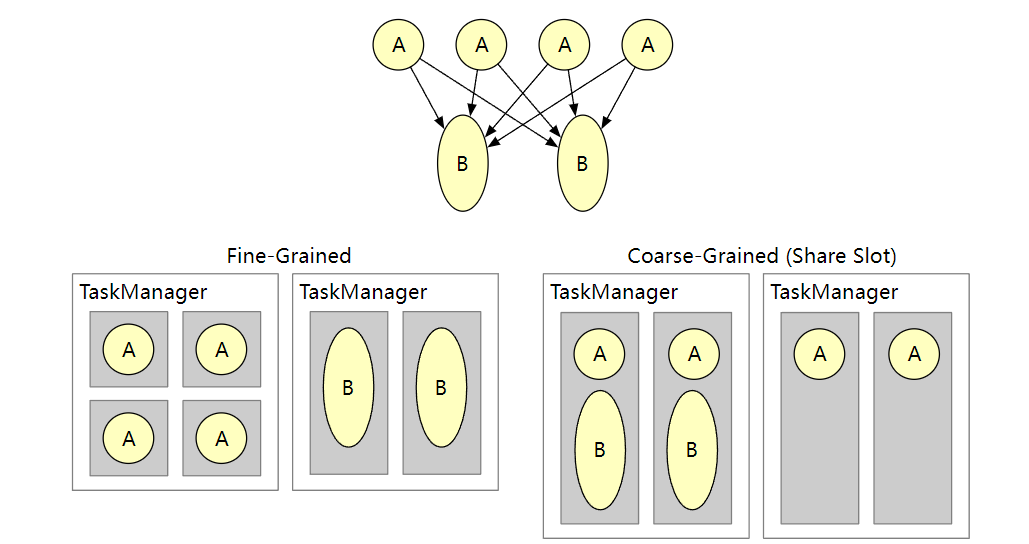

- 细粒度资源管理

- 细粒度资源管理是一项高级新功能,可提高大型共享集群的资源利用率。通过细粒度的资源管理,TaskManager 插槽现在可以动态调整大小。转换和操作符可以指定资源配置文件(CPU 大小、内存池、磁盘空间),并由 Flink 的资源管理器和任务管理器将任务管理器总资源的特定部分切掉。

- 细粒度资源管理是一项高级新功能,可提高大型共享集群的资源利用率。通过细粒度的资源管理,TaskManager 插槽现在可以动态调整大小。转换和操作符可以指定资源配置文件(CPU 大小、内存池、磁盘空间),并由 Flink 的资源管理器和任务管理器将任务管理器总资源的特定部分切掉。

连接器

- 连接器指标

- 此版本中已对连接器的度量标准进行了标准化。社区将逐渐通过所有连接器提取指标然后在下一个版本中将它们重新设计到新的统一 API 上。

- 脉冲式连接器

- 在这个版本中,Flink 添加了 Apache Pulsar 连接器。Pulsar 连接器从 Pulsar 主题读取数据,并支持流和批处理两种执行模式。在事务功能的支持下(在 Pulsar 2.8.0 中引入),Pulsar 连接器提供了一次性传递语义,以确保消息只传递给消费者一次,即使生产者重试发送消息。该连接器当前支持 DataStream API,表 API/SQL 绑定预计将在未来版本中提供。

更多详细内容,请查看更新公告。

以上就是本文的全部内容,希望对大家的学习有所帮助,也希望大家多多支持 码农网

猜你喜欢:- 简述大数据实时处理框架

- gobox中的consumer处理框架

- 流式处理框架storm浅析(上篇)

- Bootstrap开发框架界面的调整处理

- iOS换肤功能的简单处理框架

- 一个不错的音视频快速处理框架

本站部分资源来源于网络,本站转载出于传递更多信息之目的,版权归原作者或者来源机构所有,如转载稿涉及版权问题,请联系我们。

精彩绝伦的jQuery

[美] Jake Rutter / 魏 忠 / 人民邮电出版社 / 2012-6 / 59.00元

内容简介: 通过创建更具交互性的富Web界面增强用户体验 本书阐述如何利用少量的JavaScript基础知识将jQuery框架整合进网站,以创建富Web界面,并建立兼容所有主流浏览器的交互性网站。作者是一位具有丰富经验的Web设计师和开发者,通过一系列指导性步骤清晰讲述了添加交互性以创建卓越Web应用的方法和技巧。 使用jQuery可以节省大量的开发时间,开发者在没有丰富编程经验......一起来看看 《精彩绝伦的jQuery》 这本书的介绍吧!

XML 在线格式化

在线 XML 格式化压缩工具

html转js在线工具

html转js在线工具